2025年1月に突如として起きた「Deepseekショック」。これは、「Reasoning AI」の到来を告げるものでした。

高価なNVIDIAのGPUはもう必要ないのでは、という発想が市場では出ていましたが、NVIDIAのジャンセンCEOがそれに対する考えを決算発表で説明しています。

本記事でプロのファンドマネージャーの解説とともに、その実態を見ていきましょう。

投資での資産形成をお考えの方も、既に投資を始められている方も、ご自身の知識と照らし合わせながらご覧ください。

(Fund Garage編集部)

DeepSeekショックは、Inference(推論)がReasoning(推論・推理)へと進化した瞬間だった

NVIDIAのFY25Q4決算発表でとても印象的だったのは、カンファレンスコールの中でジャンセンCEOが「Inference(推論)」に異常なほど焦点を当てていたことだ。曰く、従来型の推論を意味する「Inference」という概念から、今では推理・論理的思考を伴う「Reasoning」という推論の段階へシフトしているという。

そしてこれこそが実は、件の「DeepSeekショック」の本質だということにも繋がる。

つまり、DeepSeek-R1の登場が契機となって「推論」の概念が進化し始めたという流れがあり、それをNVIDIAとしてどう受け止めているのかを明確に説明したのが今回のカンファレンスコールであった。

具体的には、Grok-3やDeepSeek-R1といったReasoning AIは、従来のAIモデルよりも100倍以上の計算能力を消費する可能性があるとジャンセンCEOは指摘。これは、DeepSeek-R1が普及すればするほどAI推論に使うGPUの需要が爆発的に増え、NVIDIAのビジネスモデルにとってむしろ有利だということを示唆している。

また、DeepSeek-R1はオープンソース化されているため、世界中のAI開発者がこの技術を活用できる点が何より重要だ、とも同氏は述べている。要するに、NVIDIAは自社のソフトウェア(CUDAやTensorRT)と組み合わせて、DeepSeekの技術をGPU上で最適に動作させることで競争優位性を維持できるビジョンを描いていると考えられよう。

だから、「DeepSeekがNVIDIAのGPUに取って代わる技術なのか?」という疑念ではなく、実際には「DeepSeekの技術はNVIDIAのGPU需要を増大させる要因となる可能性が高い」という表現が正しいと言える。

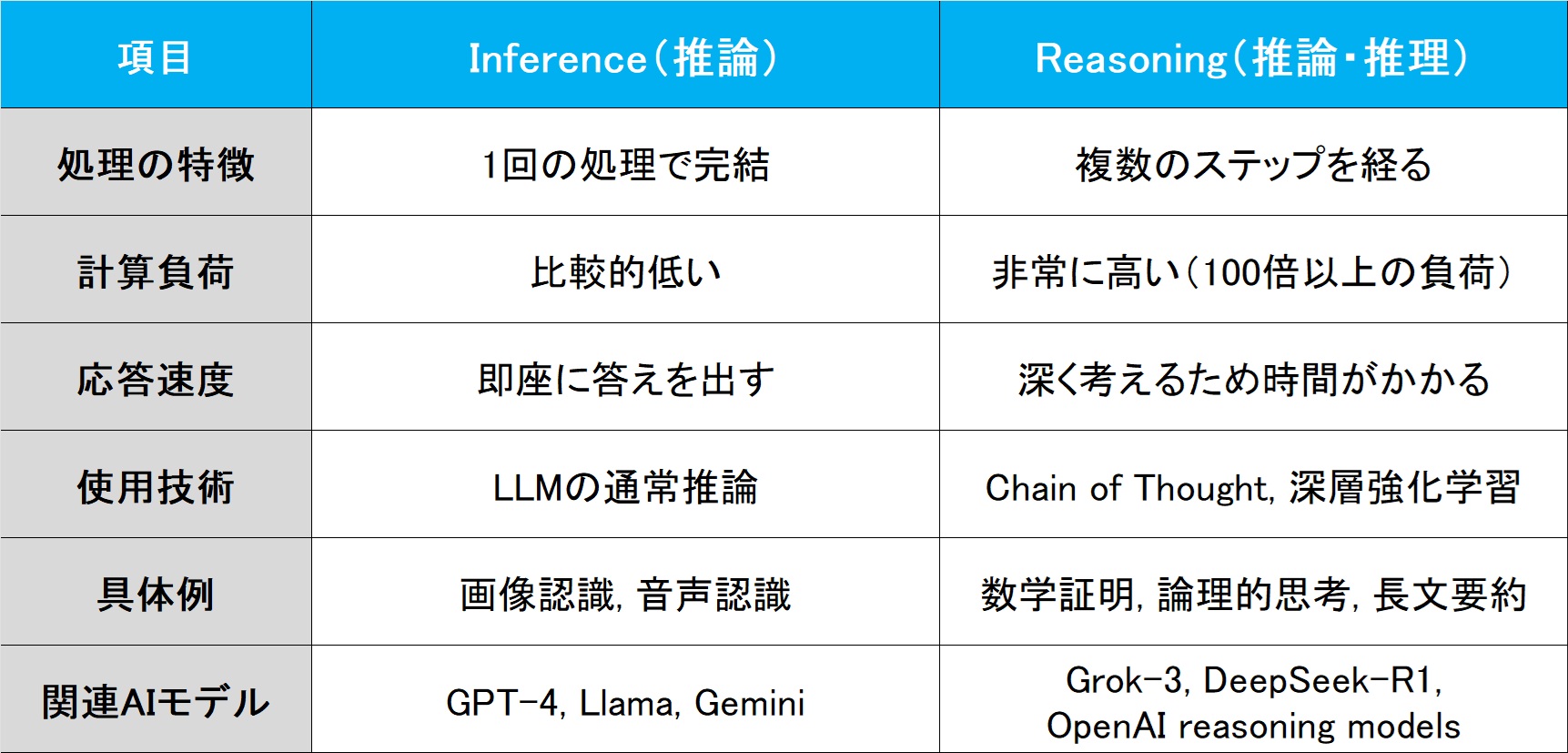

Inference(推論)と Reasoning(推論・推理)の違いとは?

以上のように、ジャンセンCEOは「Inference」と「Reasoning」という単語を使い分けていたが、実際どのような違いがあるのだろうか。

1. Inference(推論)とは?

事前学習(Pre-training)済みのAIモデルが、新しいデータに対して予測・応答を行うプロセス。

<特徴>

基本的に1回の処理で結果を出すため、計算負荷は比較的低い。GPUに最適化。

<具体例>

-

- 画像認識

例:「この画像は犬か猫か?」 → 即座に予測を出す。 - 音声認識

例:「この音声をテキストに変換せよ」 → 一度の処理で完結。 - テキスト生成(LLM)

例:「この質問に対する答えを出せ」 → 1回のトークン生成で終了。

- 画像認識

2. Reasoning(推論・推理)とは?

単純な推論ではなく、複数のステップ(Chain of Thought=思考の連鎖)を経て論理的に考え、最適な答えを導き出すプロセス。

<特徴>

複雑な推理や論理的な思考が必要なため、計算負荷が非常に高い。DeepSeek-R1、Grok-3、OpenAI GPT-4などが代表。

<具体例>

-

- 数式の証明

例:「この数学の問題を解け」→証明しながら、複数のステップを経て答えを導く(Inferenceの場合は解答を即答)。 - 会話AIの高度な応答

例:「この事象についてどう考えるか回答して」→事象について深く理解し、背景知識をもとに長文で返答(Inferenceの場合は定型文)。 - 長文の文脈理解と要約

例:「この長いドキュメントの要点を要約せよ」→全体の流れを考慮し、論理的に最適な要約を作成(Inferenceの場合は各部分を個別に要約)。

- 数式の証明

すなわち、従来のInference(推論)はシンプルにAIが学習済みの知識を適用するだけだった一方で、DeepSeek-R1の登場によりAIが考える(=Reasoningする)プロセスが推論に組み込まれるようになった。一覧表を下記に掲載するので、ぜひ保存して参考にしていただきたい。

Reasoning AIによって、GPUとASICの違いが明確に

今回のカンファレンスでのジャンセンCEOの説明を踏まえると、「推論の進化」に伴い、ASICでは処理しきれないワークロードが増えるため、汎用性のあるGPUが不可欠になるということが明らかになった。今回のカンファレンスで「GPU vs ASIC」論争は終結したと言えるかもしれない。

ならば、ASICは全く不要になるのかと言えば、そうではない。たとえばこんな感じだろう。

<ASICの主な用途>

-

- シンプルなAI推論(単純なInference) → 画像認識、音声認識など

- エッジコンピューティング(低消費電力が求められる環境) → IoTデバイス、スマホ向けAI

- 特定用途のハードウェアアクセラレーション → 例えば、GoogleのTPU(Tensor Processing Unit、テンソル・プロセッシング・ユニット)はGoogleのサービス専用に開発

ジャンセンCEOの言葉を借りれば、

“AI is advancing at light speed. We are at the beginning of Reasoning AI and Inference-Time Scaling.”

「AIは光速で進化しています。私たちは推論型AIと推論タイム・スケーリング※の始まりの段階にいます」

という。AIワークロードが数カ月単位で進化し、ハードウェアが追いつかなくなるほどのスピードになっている現状においては、特定の用途に対して力を発揮するASICが新しいモデルに適応するのは困難かもしれない。

※…Inference-Time Scalingとは、AIモデルに思考する時間を与えること。そうすることで複数の解決策を導き出したり、論理的推論をしたりすることが可能になる。

まとめ

- FY25Q4決算を前にして突如現れたLLMモデルのDeepSeek-R1は市場を震撼させたが、NVIDIAのジャンセンCEOの見解は、①DeepSeek-R1のような「Reasoning AI」は膨大な計算能力を消費するため、NVIDIA GPUにとってむしろ好都合 ②LLM開発の民主化が進み、AI市場のさらなる拡大が期待できる といったポジティブなものであった。

- Inferenceとは、事前学習(Pre-training)済みのAIモデルが、新しいデータに対して予測・応答を行うプロセスを指す。

- Reasoningとは、単純な推論ではなく、複数のステップ(Chain of Thought=思考の連鎖)を経て論理的に考え、最適な答えを導き出すプロセスのこと。

- ジャンセンCEOの説明を踏まえると、「推論の進化」に伴い、ASICでは処理しきれないワークロードが増えるため、汎用性のあるGPUが不可欠になるということも明らかになった。

“Light speed”で日々進化しているAI。それに伴って「どの半導体」が「どのような場面・用途で」活躍していくのかを見極める必要性があることを、今回のDeepSeekショックを通して実感できたのではないだろうか。

毎度私が注意喚起しているように、ここでも、「半導体関連銘柄」と一括りにする危険性が見てとれた。

編集部後記

こちらは、Fund Garageプレミアム会員専用の「プレミアム・レポート」の再編集版記事です。

公開から半年以上経った記事になりますので、現在の情勢とは異なる部分がございます。当時の市場の空気と、普遍的な知見の皆様にお届けできれば幸いです。

また、こちらは無料版記事のため、最新の情報や個別企業の解説についてはカットしております。

<FG Free Report では割愛>となっている箇所に関心をお持ちになられた方は、是非、下記ご案内よりプレミアム会員にお申し込みください。

有料版のご案内

Fund Garageのプレミアム会員専用の「プレミアム・レポート」では、個別銘柄の買い推奨などは特に行いません。

これは投資家と銘柄との相性もあるからです。「お宝銘柄レポート」とは違うことは予めお断りしておきます。お伝えするのは注目のビジネス・トレンドとその動向がメインで、それをどうやってフォローしているかなどを毎週お伝えしています。

勿論、多くのヒントになるアイデアは沢山含まれていますし、技術動向などもなるたけ分り易くお伝えしています。そうすることで、自然とビジネス・トレンドを見て、安心して長期投資を続けられるノウハウを身につけて貰うお手伝いをするのがFund Garageの「プレミアム会員専用プレミアム・レポート」です。