みなさんは、AIに「学習」と「推論」という2つの分野があることをご存知ですか。今や、AI(生成AI)無くしてビジネストレンドは語れないほど、世界を動かしているAIですが、この「学習」と「推論」プロセスの違いを理解することが、今後の投資活動において不可欠になっていきます。

今回は、そんな「AIの学習と推論」のこれまでとこれからについて、プロのファンドマネージャーが解説します。

投資での資産形成をお考えの方も、既に投資を始められている方も、ご自身の知識と照らし合わせながらご覧ください。

(Fund Garage編集部)

2024年、AIは「推論」分野に拡がる

AIの「学習」と「推論」

2023年は、AIのひとつである「生成AI」が脚光を浴びた。逆に言えば、「AI=生成AI」という認識が一般的だったとも言えるだろう。

そしてその爆発的な勢いは、金利が上昇しようが、地政学リスクが加速しようがお構いなしに、右肩上がりのトレンドを描き続けた。具体的には、SOX指数を筆頭に、NASDAQや「マグニフィセント・セブン(除くテスラ)※1」の上昇が見られた。

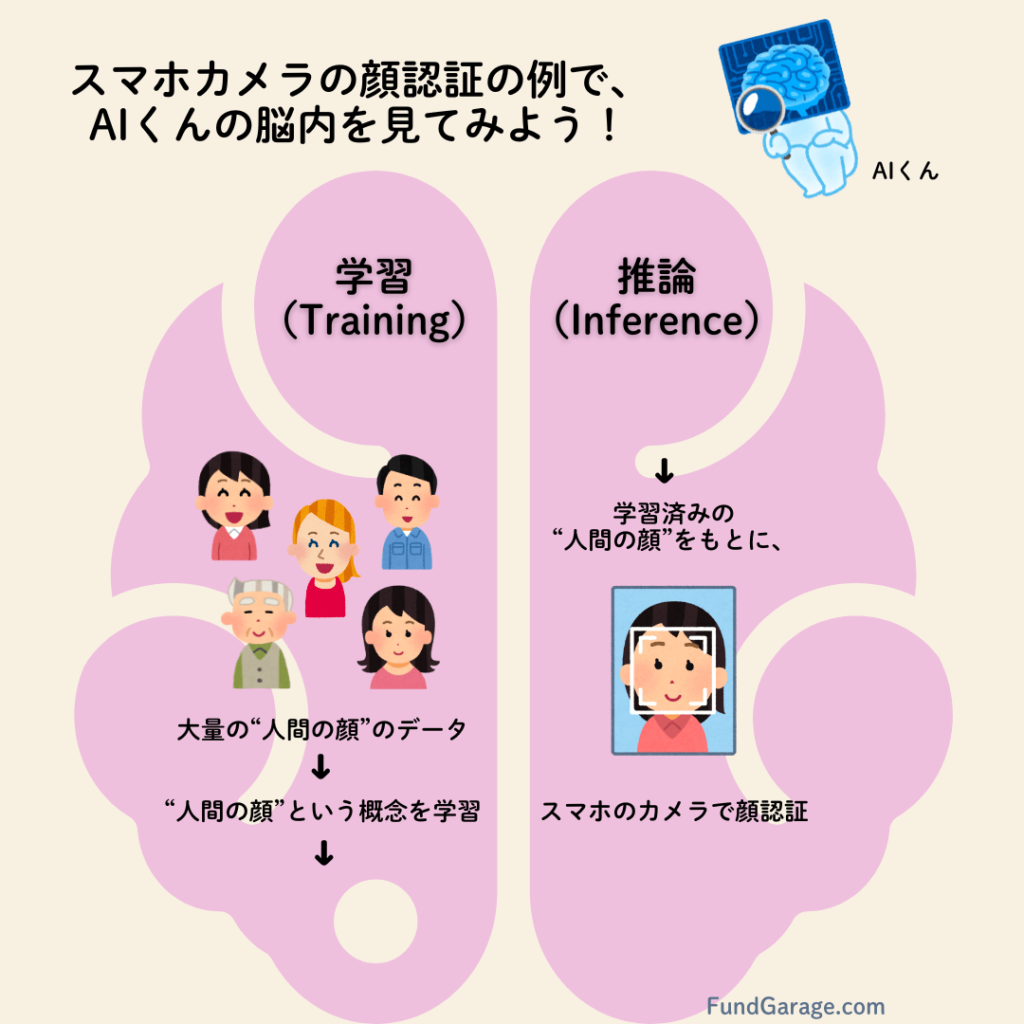

ただ、人間に右脳と左脳があるように、AIにも二つの側面がある。これらはすなわち、「学習(Training)」と「推論(Inference)」である。そしてこれらのプロセスの違いを理解することが、2024年の投資環境を上手に戦う最初の一手になるだろう。

AIの学習と推論を整理すると、以下のようになる。

学習(Training)

-

-

- 大量のデータを使って、モデルを訓練(=大規模言語モデルなど)。

- 高度な計算能力とメモリが必要。

- このフェーズでは、GPUが高いパフォーマンスを発揮する。

-

推論(Inference)

-

-

- 訓練済みのモデルを使って、新しいデータに対する予測や分析を行う。

- レイテンシー(応答時間)と電力効率が重要。

- このフェーズでは、GPUのみならず、エッジAIではNPUが高いパフォーマンスを発揮する。

-

一般的に「推論」という言葉は、論理的な結論を導くプロセスを指す。しかしAIの文脈では、訓練データから学んだ知識(言語の構造、文脈、スタイル、視覚的なパターンなど)を利用して、新しいテキストや画像を生成する、つまり新しいデータに応用するという意味での「推論」となる。

すなわち、生成AIは、人間のように複雑な論理的推論や深い理解を行うわけではなく、パターン認識とデータからの学習に基づいて動作するということだ。

そして2024年は遂に、その「推論(Inference)」の世界が大きく動き始めると予想される。

※1…マグニフィセント・セブンとは、「GAFAM」(アルファベット(GOOG)、アップル(AAPL)、アマゾン・ドットコム(AMZN)、メタ・プラットフォームズ(META)、マイクロソフト(MSFT))に、エヌビディア(NVDA)とテスラ(TSLA)を加えたものである。

AIの推論とNPU

前述のように、AIの推論とは、モデルが学習した知識を実際の状況に適用する段階のことだ。たとえば、スマートフォンのカメラで顔を認識したり、音声アシスタントが質問に答えたりする場合などがそれにあたる。

この推論プロセスは通常、リアルタイム(またはほぼリアルタイム)で行われ、低レイテンシー・高効率・低消費電力が要求される。

そこで注目されるのが、NPU(Neural Processing Unit)という半導体だ。これは既にiPhoneをはじめ、多くのスマートフォンに搭載されている、AIの推論処理に特化したプロセッサである。

NPU(Neural Processing Unit)は、AIモデルの推論を高速かつ効率的に処理できるため、特にエッジデバイス(スマートフォン、自動車、IoTデバイスなど)におけるAIタスクに適している。

例えば、2023年はAMDとインテルから「AI PC(AI パソコン)※2」と新たに定義されたノートパソコンで利用される新しいタイプのCPUが登場した。今後NPUは、この分野でも加速すると言われている。

これには、例えばマイクロソフトが11月から提供を開始した「Copilot」といった、アプリケーション・ベースの「パソコンのAI化」の流れも大きく影響している。そのひとつのキーワードが「Neural Network(=ニューラルネットワーク)※3」であり、その処理をするのがまさしくこのNPUこと、Neural Processing Unitなのだ。

先週、メモリー半導体大手のマイクロンテクノロジー(MU)の決算発表があった。詳細は今号では割愛するが、その内容は市場予想を遥かに凌駕するものであった。キーワードは、「アクセラレーティッド・コンピューティング」の世界の話で、HBM(High Bandwidth Memory)という高帯域幅と高性能を提供するメモリの需要が、メモリー半導体業界の状況を一変させているという。

そしてこのマイクロンテクノロジーのCEOも、まだまだAIは始まったばかりだということを繰り返していた。

この一年間、何人のCEOの口から同じ言葉を聞いたか分からない。そして異口同音に、「インターネット革命の時以上に大きな変革の波が来ている」という。

というわけで2024年は、推論分野が加わった生成AIのビッグ・ウェーブに期待したい。

※2…AI PCについては、以前の無料記事『AMD〜AI分野のオールラウンダー〜』を参照。

※3…ニューラルネットワークとは、AIの深層学習(ディープラーニング)に利用されるモデルのこと。人間の脳のニューロンの動作を模倣している。

まとめ

今回は、以下の内容でAIの学習と推論分野についてお伝えした。

- AIには、「学習(Training)」と「推論(Inference)」という2つの側面がある。

- 「学習」は、大量のデータを使ってモデルに学習させることである。一方で「推論」は、学習済みモデルを新しいデータに応用することである。

- 生成AIは、人間のように複雑な論理的推論や深い理解を行うわけではなく、パターン認識とデータからの学習に基づいて動作する。

- NPU(Neural Processing Unit)とは、AIの推論処理に特化したプロセッサであり、主にエッジデバイスに使用されている。

- 2024年からは、AIの推論分野に大きな期待が寄せられている。

ひとまずは生成AIという「学習(Training)」側のAIが発達し始めた2023年に続き、2024年は「推論(Inference)」の方も動き出しそうだ。しかし、それはあくまで「はじまり」でしかない。

今でも忘れないが、インターネットが始まった当初、多くの人達が「パソコン通信の大規模版の話でしょ。秋葉原のオタクの世界だよね」とにべもなかった。その後によく使われた表現は「パソコンやってる?」とか、「インターネットやってる?」というものだ。今の世代の人に「インターネットやってる?」という言い方は、恐らく日本語表現としてさえ伝わらないだろう。

ただそんな時代は、90年代の終わりから2000年代の初めにまで、確実に存在した。でも今や、パソコンもインターネットも、息をするのと同じぐらい、無意識に日常のものだ。寧ろ「デジタル・デトックス」なんて反対のシチュエーションまであるぐらいになった。

恐らく「AI」というのも、同じような存在になるだろう。そしてそれはまだまだ当分先の話だ。その扉の片方が、2024年に開き始める。

編集部後記

こちらは、Fund Garageプレミアム会員専用の「プレミアム・レポート」の再編集版記事です。

公開から半年以上経った記事になりますので、現在の情勢とは異なる部分がございます。当時の市場の空気と、普遍的な知見の皆様にお届けできれば幸いです。

また、こちらは無料版記事のため、最新の情報や個別企業の解説についてはカットしております。

<FG Free Report では割愛>となっている箇所に関心をお持ちになられた方は、是非、下記ご案内よりプレミアム会員にお申し込みください。

有料版のご案内

Fund Garageのプレミアム会員専用の「プレミアム・レポート」では、個別銘柄の買い推奨などは特に行いません。

これは投資家と銘柄との相性もあるからです。「お宝銘柄レポート」とは違うことは予めお断りしておきます。お伝えするのは注目のビジネス・トレンドとその動向がメインで、それをどうやってフォローしているかなどを毎週お伝えしています。

勿論、多くのヒントになるアイデアは沢山含まれていますし、技術動向などもなるたけ分り易くお伝えしています。そうすることで、自然とビジネス・トレンドを見て、安心して長期投資を続けられるノウハウを身につけて貰うお手伝いをするのがFund Garageの「プレミアム会員専用プレミアム・レポート」です。